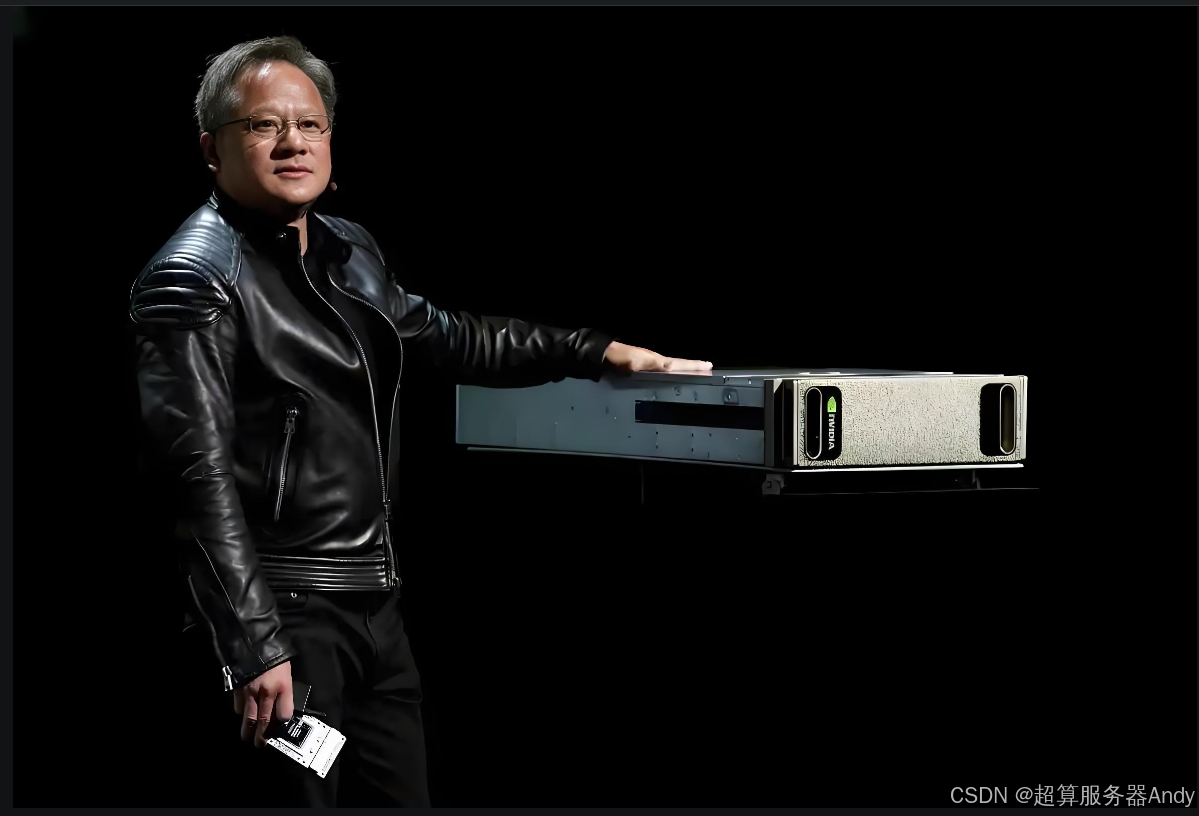

当一块芯片能顶18000个GPU,AI算力战争进入新纪元

“黄仁勋又双叒叕放核弹了!”在台北电脑展的镁光灯下,英伟达用一场技术风暴宣告:AI算力的天花板,正在被彻底击穿。从单芯片性能碾压18000个GPU的“算力怪兽”GB300,到让H100甘拜下风的RTX PRO Server,再到液冷技术引发的数据中心革命,英伟达用一套组合拳重新定义了AI时代的底层逻辑。这场发布会,究竟藏着哪些改变行业格局的硬核技术?我们为你拆解。

五大技术突破,重新定义AI基础设施

1. GB300芯片:算力密度突破物理极限

- 性能炸裂:搭载288GB HBM3e显存的GB300,显存容量是RTX 4090的12倍,推理性能较上代提升50%,通信带宽飙升至800GB/s。更颠覆的是,单个GB300节点即可媲美2018年美国能源部Sierra超算的18000个GPU集群。

- 散热革命:全液冷设计让单机架功耗高达120千瓦,却将散热效率提升3倍。这意味着,过去需要整栋楼支撑的算力,未来可能塞进一个机柜。

- 技术深挖:HBM3e显存采用3D堆叠技术,单位面积带宽突破1TB/s,直接解决大模型训练中的“内存墙”问题。而800GB/s的NVLink带宽,让多芯片互联延迟低至微秒级,为万卡集群训练铺平道路。

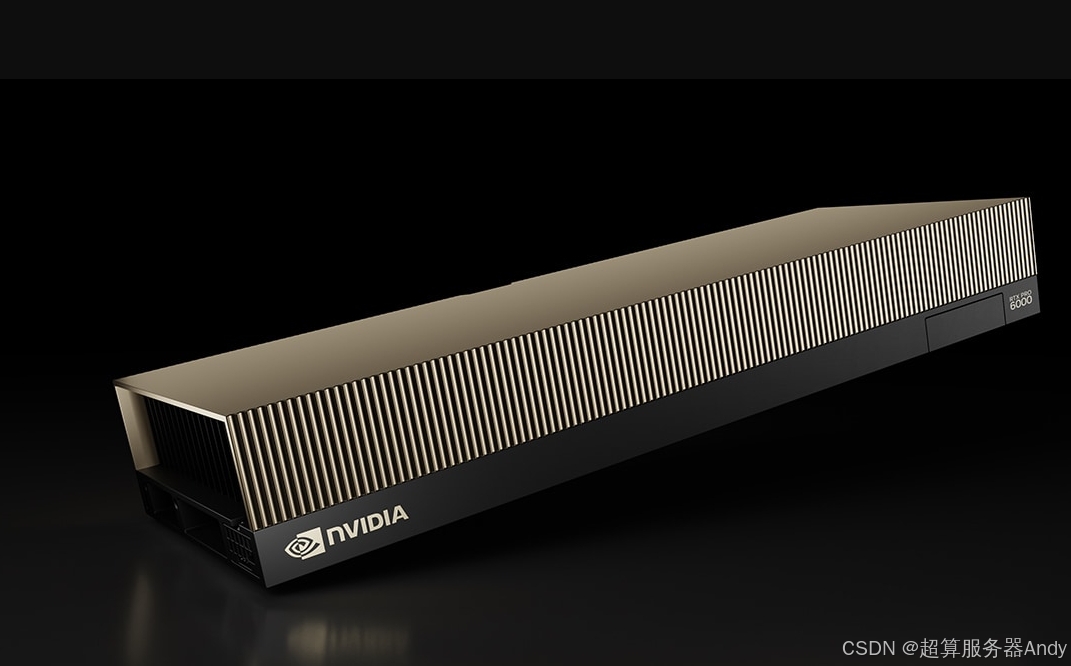

2. RTX PRO Server:企业级AI的降本神器

- 性能碾压:搭载8块RTX PRO 6000 GPU的服务器,运行DeepSeek-R1模型的效率是H100的4倍。每投入500万美元,企业可多生成4倍Token,单位算力成本直降50%。

- 硬件优化:超微推出的SYS-212GB-NR边缘服务器,通过液冷+架构重构,设备数量减少50%,能耗降低30%。这直接击中中小企业“算力贵、部署难”的痛点。

- 行业影响:金融、医疗等领域的大模型微调成本将大幅下降,中小企业接入AI的门槛被拉低到百万美元级。

3. 液冷技术:数据中心进入“千瓦级”时代

- 市场爆发:申菱环境液冷产品营收暴涨190%,中国液冷服务器市场2028年预计达102亿美元,年复合增长率47.6%。

- 技术价值:传统风冷已无法满足AI芯片的散热需求。液冷可将PUE(电能利用效率)压低至1.1以下,单机架算力密度从10kW级跃升至100kW级。

- 生态联动:英伟达的全液冷方案与GB300深度绑定,未来数据中心可能从“机房”演变为“算力工厂”。

4. 开源生态:机器人与量子计算的“双核驱动”

- 机器人革命:开源模型GR00T N1让迪士尼36小时开发出高仿真机器人Blue,任务成功率提升30%。这背后是英伟达Omniverse平台的实时仿真能力支撑。

- 量子跃迁:DGX Quantum平台融合经典计算与量子叠加态,丰田借此将固态电池研发周期从10年压缩至2年。量子计算正从实验室走向工业界。

- 战略意图:通过开源降低技术门槛,英伟达欲打造AI时代的“安卓生态”,让开发者成为其算力产品的“自来水”。

5. “星际之门”AI工厂:600亿美元的算力豪赌

- 超级工程:占地400万平方英尺(约37个足球场)、投资600-800亿美元的“星际之门”,目标是将Blackwell芯片封装成吉瓦级算力集群。

- 生态闭环:企业可通过“积木式”组合,快速搭建私有AI超算。黄仁勋的潜台词清晰:未来AI竞争,本质是算力基础设施的军备竞赛。

- 行业警示:当算力成为“水电煤”般的基础资源,中小企业或将被迫站队——要么接入英伟达生态,要么被边缘化。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册