在联网服务器上部署(ollama+docker),前半部分参考这个

AI 知识库的 O1 时刻!蚂蚁KAG或将取代RAG【含喂饭级教程】-CSDN博客

1.遇到的问题,端口3306被联网服务器mysql端口占用

然后把那个端口进程停了即可,docker-compose.yml文件不用改

联网直接,路径运行docker-compose up -d就会拉下镜像,启动容器

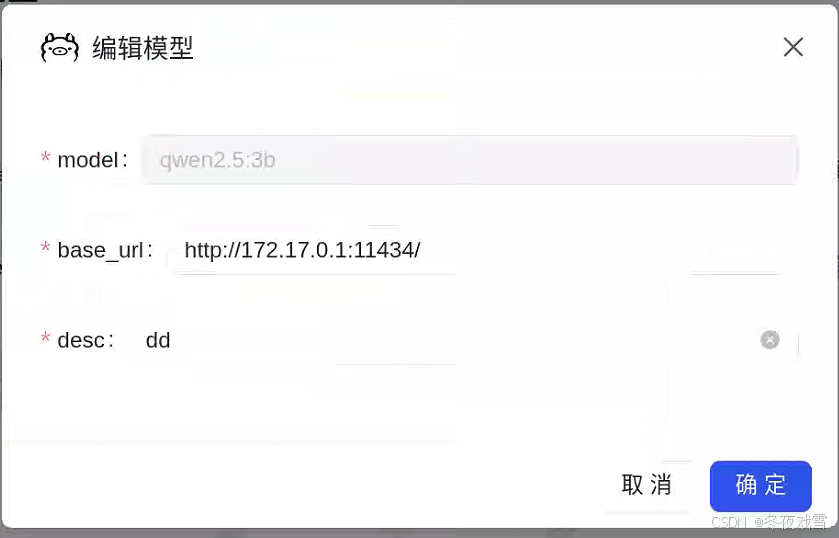

2.先通用后模型配置,来就行

模型配置注意docker0网关:然后宿主机的111434端口,即ollama serve 监听的端口

断网服务器上部署(xinference + docker)

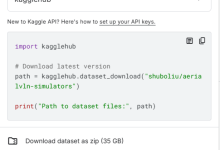

1.把对应镜像进行打包到服务器上

2.docker 运行起来,no access for “xxx%xxx”

2.1进入mysql,修改权限,可以查mysql-user表,加一个对应权限,gpt下

2.2重启mysql容器,restart server 容器就好了

3.访问前端8887页面,无显示

因为浏览器问题,清除下浏览数据,即可

4.“ illegal params graphstore is null ”,“设置llm模型报的run time error”(这里我是调用本地模型)

第一个问题解决是先通用后模型设置

通用模型的向量模型配置即是本地xinference的api调用

http://xx.xx.xx.xx:9997/v1 apikey=EMPTY

第二个问题是因为设置的url错误,我这里是本地启动的千问模型和一个bce的向量模型,所以调用方式是本地调用,跟联网的api调用有区别,这里设置注意。

官网给的xinference默认跟vllm一样,其实curl、telnet测试下来,xinference启动的llm模型,设置为mass 调用模型即可,http://xx.xx.xx.xx:9997/v1 EMPTY

然后正常访问测试即可

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册