在任何云存储平台,客户端看见的是易读路径或对象键,而底层保存的却是被分片、复制、加密并散落在全球数千磁盘上的实际数据。连接这两层世界的关键枢纽是 命名服务器:它维护文件与对象的命名空间、记录每个数据块或对象副本的精确位置,并在高并发场景下保证原子性、一致性与可恢复性。HDFS 的 NameNode、GFS 的 Master、Ceph 的 MDS/MON 族、OpenStack Swift 的 Proxy 以及对象存储中的 分区元数据库 都是这一思想的不同落地。理解它们的设计权衡,对于构建高可靠、大规模、低时延的云原生存储至关重要。

命名为何在云存储里成为首要问题

-

目录层次、对象键与 ACL 等元信息不会随数据扩容自动生长,需要独立服务跟踪;这就是命名服务器存在的根本理由。(Database Trends and Applications)

-

当节点数突破上千、数据量迈入 PB 乃至 EB 级,一次 ls 或 head 请求若让客户端遍历全部节点,将不可接受;集中或分布式元服务把这一步骤收敛到 一次或数次 网络跳数。(SpringerLink)

名称服务器的核心职能

| 命名空间管理 | 路径 → inode/id 映射;支持重命名、软链接、配额 | B 树、LSM、目录分片 |

| 位置映射 | inode/id → 副本物理位置 | 一致性哈希、CRUSH、ring |

| 元数据一致性 | 并发修改冲突检测 | 乐观锁 + 版本号、Leases |

| 高可用 | 故障转移、恢复顺序 | Paxos / Raft、双活选主 |

| 安全与审计 | ACL、租约、访问追踪 | Kerberos、Token、审计日志 |

元数据只占总存储容量的几个百分点,却是系统可用性的咽喉;任何失真都会导致“数据仍在磁盘却永远找不到”的灾难。(Apache Hadoop, Google Research)

典型实现一览

Hadoop HDFS NameNode

单主架构简化了逻辑:所有目录结构、块映射保存在热点内存中,并以 fsimage + editlog 方式落盘;以 checkpoint 把热日志合并到快照,降低重启时间。(Apache Hadoop, Cloudera Documentation) 高可用版本通过 JournalNode 复制 editlog,以 ZooKeeper 协调主备切换,缓解了单点风险。(GeeksforGeeks)

Google File System / Colossus

GFS Master 记录文件→Chunk 列表与副本位置;Colossus 进一步将元信息分片、去中心化,并把 Chunk 缩小至 1MB,以支持实时流媒体和搜索索引写入。(Google Research, WIRED)

Ceph MON + MDS

-

MON 使用 Paxos 投票维护整集群图,包括 OSD map 与 CRUSH 规则。(Ceph Documentation, Wikipedia)

-

MDS 仅在 CephFS 场景下启动,负责 POSIX 目录树;可横向扩展到 N 台并动态平衡 inodes。(Red Hat Documentation)

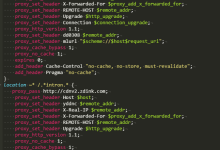

OpenStack Swift Proxy

请求入口 Proxy 根据环形一致性哈希表将对象路由至对应存储节点,同时缓存对象→分片位置映射;因为它是无状态进程,可轻松水平扩容避免瓶颈。(OpenStack Docs)

公有云对象存储

-

Amazon S3 把桶和对象键拆分为 partition,每个分区维护独立元数据库,并使用 key prefix → partition 哈希路由,配合一致性热度迁移。(Amazon Web Services, Inc.)

-

Azure Blob Storage 采用 DNS + 路径编码方式,前缀直接映射到账户分区,再由后端元服务器解析层级目录与属性。(Microsoft Learn)

-

阿里巴巴 Pangu 通过 三副本 Paxos 保护元数据,写路径只需一次 RTT 即提交,读流量就近路由。(Alibaba Cloud)

学术视角:OceanStore 与未来全局命名

OceanStore 早在 2000 年就提出 全球可变长度 GUID 方案:将名字分级散布于地理域,任何客户端可在最近副本解析;该理念今日在 serverless metadata 上再度复活。(People at UChicago)

设计挑战与技术要点

扩展性 元信息量与文件数近线性增长。业界采用 目录散列 + 子树分片 或 表格分区,并允许在运行时迁移分区,以避免热目录成为热点。(SpringerLink)

高可用与一致性 Paxos 与 Raft 是事实标准:通过法定票数写入日志,再异步应用到内存状态机,做到了读写线性一致而不损性能。(Medium, Medium, CNCF)

性能优化

-

写放大:元数据常常很小,合并日志、批量提交可减少随机写。

-

客户端缓存:租约或 version ID 控制失效,降低 RTT。

-

零拷贝读取:对象存储让数据平面直通存储节点,命名服务器只返回位置信息。(Apache Hadoop)

可观察性与多租户安全 细粒度审计日志支持合规;多租户隔离需在元服务层面执行 ACL 和配额防止噪声邻居效应。(Microsoft Learn, Amazon Web Services, Inc.)

趋势与展望

-

多主元数据:Colossus 已展现全活 Master 的可行性;更多系统正把 Paxos/Raft 多主推广到全局。(WIRED)

-

Serverless Metadata:以函数即服务运行元服务,根据负载瞬时扩缩,每毫秒计费,提升成本弹性。

-

AI 驱动智能布局:分析访问模式后重排分片,提高预取命中率并降低尾延迟。

Python 极简示例:键值型命名服务器原型

import socketserver, json, threading

class NameDB:

def __init__(self):

self._lock = threading.Lock()

self._table = {} # 路径 -> [位置列表]

def put(self, path, locations):

with self._lock:

self._table[path] = locations

def get(self, path):

with self._lock:

return self._table.get(path, None)

db = NameDB()

class Handler(socketserver.BaseRequestHandler):

def handle(self):

data = self.request.recv(4096).decode()

req = json.loads(data)

if req['op'] == 'put':

db.put(req['path'], req['loc'])

self.request.sendall(b'OK')

elif req['op'] == 'get':

loc = db.get(req['path'])

self.request.sendall(json.dumps(loc).encode())

if __name__ == '__main__':

server = socketserver.ThreadingTCPServer(('0.0.0.0', 9000), Handler)

threading.Thread(target=server.serve_forever, daemon=True).start()

print('NameServer listening on 9000')

这一百余行的粗陋脚本用线程锁保障并发安全,演示了路径→物理位置映射的最小闭环:客户端写入或查询元信息时,只和命名服务器交互一次即可拿到数据节点列表;在真正生产系统里,你需要替换锁为 Raft、将表持久化为 write‑ahead log 并实现租约与快照。

通过梳理上文,我们发现:命名服务器虽不直接存用户比特,却决定了云存储的 可靠性、延迟 与 水平扩展上限。面向未来的设计正从“单主内存字典”演进到“多主 + 共识 + 热自迁移”乃至 serverless 架构;只有把元数据视作一等公民,云原生应用的无限扩容愿景才有坚实地基。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册