目录

🧱 一、硬件推荐方案(个人桌面级 AI 主机)

🔧【基础配置清单】

💡 推荐二手平台:

⚙️ 二、训练和推理环境搭建建议

✅ 1. 安装推荐系统与环境

✅ 2. 推荐训练方式

👉 使用 QLoRA + PEFT 微调 Qwen2.5-7B/14B

✅ 3. 推理方式(资源省,速度快)

🧰 三、可选配件建议(辅助体验)

📦 四、附送:训练启动脚本模板(QLoRA + PEFT)

✅ 总结

好,既然你确定了想自己组装一台训练+推理服务器,并希望我提供详细配件建议、价格参考和微调环境建议,那我就来给你一个个人性价比装机方案(2025年4月版),目标是:

-

预算尽量控制在 2 万元人民币以内

-

能运行通义千问 Qwen2.5 系列(7B 或 14B)

-

支持 LoRA、QLoRA 等轻量级微调

-

还能日常使用、扩展性强

🧱 一、硬件推荐方案(个人桌面级 AI 主机)

🔧【基础配置清单】

| GPU | RTX 3090 24GB × 2(二手) 或 A6000 48GB × 1(二手) | 支持 QLoRA 训练,3090 显存大,性价比高 | 5500 × 2 或 8500(A6000) |

| CPU | AMD Ryzen 9 7950X 或 7900X (如果用 DDR5) Intel i9-12900K 也可以 | 高线程数+兼容性强 | 2500~3000 |

| 主板 | ASUS ROG Strix X670E 或 B650-E (支持双卡+DDR5) | 注意选带 PCIe ×16 ×2 的 | 1500~2000 |

| 内存 | 128GB DDR5(32G×4)或 DDR4 | 显卡吃显存,训练吃内存 | 1600~2000 |

| SSD | NVMe PCIe 4.0 ×4 接口 2TB | 推荐三星 980 Pro、WD SN850 | 800~1000 |

| 电源 | 1300W 金牌(海韵、振华等) | RTX 3090 功耗很高 | 1000 |

| 散热 | 九州风神水冷360 或 冰龙 | 保证 CPU 训练时温度稳定 | 300~600 |

| 机箱 | 大塔式:酷冷至尊 HAF 或 利民 S1 | 放得下双显卡+高通风 | 400~800 |

| 显示器、键鼠 | 任意现有设备 | 省钱 | – |

✅ 总价(含双 3090):约 1.8 万左右 ✅ 总价(含 A6000 单卡):约 1.6 万左右

➕如果以后有钱,再加一张显卡也可以横向扩展

💡 推荐二手平台:

-

闲鱼(关键词:3090 全新、A6000)

-

京东二手、淘宝企业回收

-

本地电脑城蹲矿卡清货(优质货源)

⚙️ 二、训练和推理环境搭建建议

✅ 1. 安装推荐系统与环境

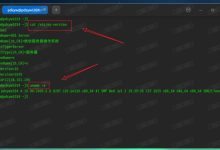

Ubuntu 22.04 LTS (稳定性强) Python 3.10+ conda 或 micromamba CUDA 12.1(适配 3090) PyTorch 2.1+ Transformers + PEFT + bitsandbytes

✅ 2. 推荐训练方式

👉 使用 QLoRA + PEFT 微调 Qwen2.5-7B/14B

pip install transformers peft accelerate bitsandbytes datasets

-

模型加载:Qwen/Qwen2.5-7B-Chat

-

数据格式:alpaca 或 chatml

-

推荐使用 LoRA 方式,只训练 adapter 权重,节省显存

-

用 bnb_config 启用 int4 权重加载

✅ 3. 推理方式(资源省,速度快)

-

量化为 GGUF,使用 llama.cpp

-

或使用 vLLM + API 推理

-

如果你用 A6000,可以跑 14B 推理毫无压力

🧰 三、可选配件建议(辅助体验)

| 多块 SSD | 一块存权重(模型)一块存数据,提升训练效率 |

| 显卡支架 | 支撑双卡防止主板变形 |

| UPS 电源 | 避免断电丢任务(微调长时间运行) |

| 显卡桥接 | 双卡训练不必须 NVLink,但部分框架支持 NVLink |

📦 四、附送:训练启动脚本模板(QLoRA + PEFT)

accelerate launch train.py \\ –model_name_or_path Qwen/Qwen2.5-7B-Chat \\ –dataset data/alpaca.json \\ –use_peft –lora_rank 8 \\ –quantization int4 \\ –output_dir ./output/qwen2.5-7b-qlora \\ –per_device_train_batch_size 2 \\ –gradient_accumulation_steps 8 \\ –learning_rate 2e-5 \\ –num_train_epochs 3

可以基于 llama-factory 或 transformers 官方训练 LoRA。

✅ 总结

| 显卡 | 2 × RTX 3090 二手 or 1 × A6000 48G |

| 内存 | 128GB DDR4/DDR5 |

| 微调方式 | QLoRA / LoRA / DPO |

| 支持模型 | 通义 Qwen2.5-7B / 14B |

| 预算 | 控制在 16000~22000 元 |

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册