阿里云服务器负载均衡服务器搭建方案,服务器负载均衡如何实现?

负载均衡是提升服务器性能、可靠性和扩展性的关键技术,主要用于将流量合理分配到多个服务器,避免单点过载。以下是详细的搭建方案及实现方法:

一、负载均衡方案分类

硬件负载均衡

-

设备:F5 BIG-IP、Citrix ADC、A10 Networks等。

-

优势:高性能、高稳定性、内置安全功能(如DDoS防护)。

-

缺点:成本高,适合大型企业或关键业务。

软件负载均衡

-

常用工具:

-

Nginx:适用于HTTP/HTTPS/TCP,配置灵活。

-

HAProxy:专注TCP/HTTP层,支持高并发。

-

LVS(Linux Virtual Server):基于Linux内核,性能接近硬件。

-

-

优势:成本低、灵活性高,适合中小型场景。

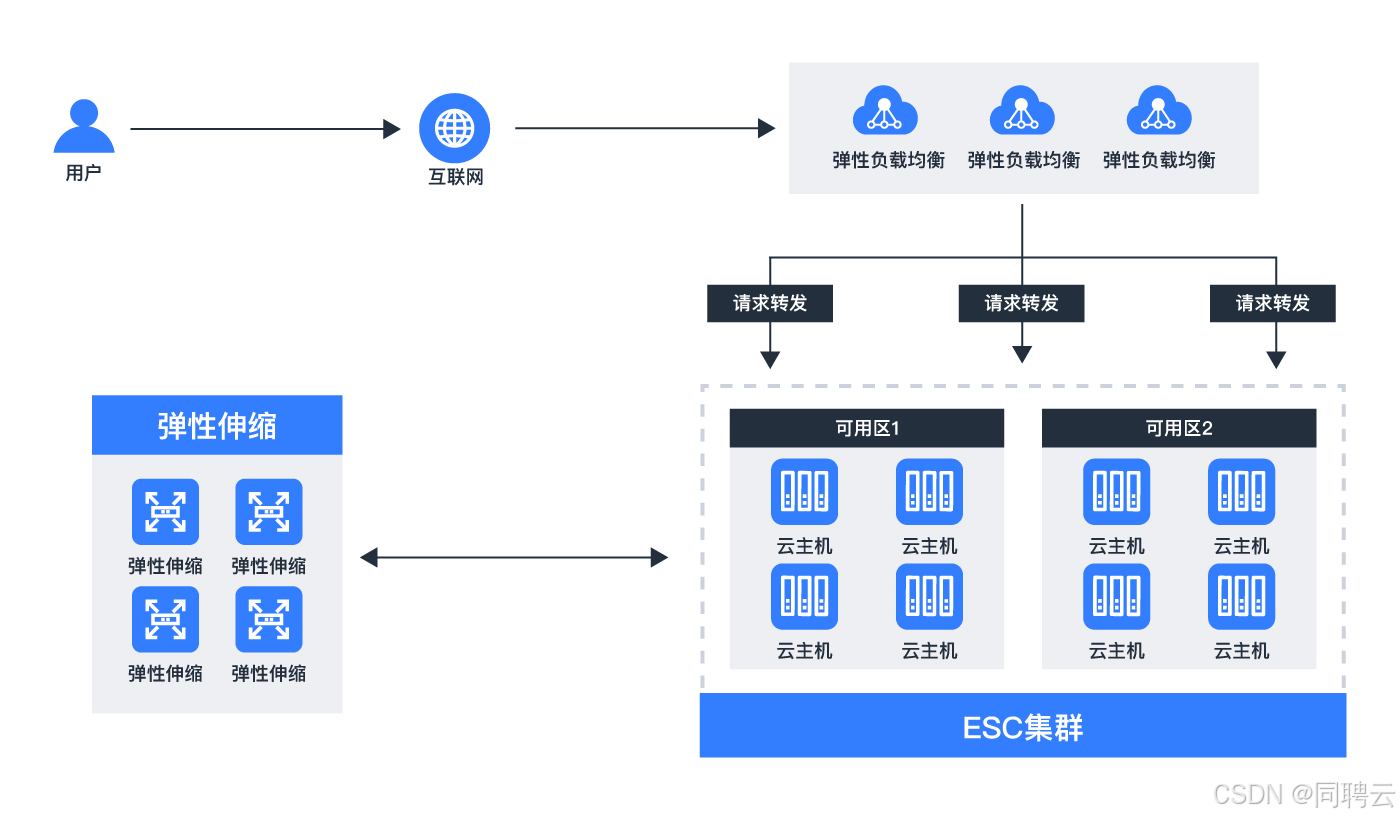

云服务负载均衡

-

服务商:AWS ALB/NLB、阿里云SLB、腾讯云CLB等。

-

优势:全托管、自动扩展、集成云监控,适合云原生架构。

二、负载均衡核心实现步骤

1. 架构设计

-

拓扑结构:

客户端 → 负载均衡器 → [后端服务器1, 后端服务器2, …]

-

部署模式:

-

四层(L4):基于IP+端口转发(如LVS、HAProxy的TCP模式)。

-

七层(L7):基于HTTP头部、URL等应用层信息(如Nginx、HAProxy的HTTP模式)。

-

2. 负载均衡算法选择

-

轮询(Round Robin):均匀分配请求。

-

加权轮询(Weighted Round Robin):根据服务器性能分配权重。

-

最少连接(Least Connections):优先选择连接数最少的服务器。

-

IP哈希(IP Hash):同一客户端IP固定访问某台服务器(保持会话)。

-

一致性哈希(Consistent Hashing):减少服务器变动对会话的影响。

3. 配置示例(以Nginx为例)

http {

upstream backend {

# 定义后端服务器集群

server 192.168.1.101:80 weight=3; # 权重3

server 192.168.1.102:80;

server 192.168.1.103:80 backup; # 备用服务器

# 使用最少连接算法

least_conn;

}

server {

listen 80;

location / {

proxy_pass http://backend;

# 会话保持(基于Cookie)

proxy_set_header Cookie $http_cookie;

}

}

}

4. 高可用性(HA)设计

-

双机热备:通过Keepalived实现VRRP协议,防止负载均衡器单点故障。

主LB(VIP: 192.168.1.100) ↔ 备LB(VIP: 192.168.1.100)

-

配置Keepalived:

vrrp_instance VI_1 {

state MASTER # 主节点为MASTER,备节点为BACKUP

interface eth0

virtual_router_id 51

priority 100 # 主节点优先级更高

virtual_ipaddress {

192.168.1.100 # 虚拟IP(VIP)

}

}

5. 健康检查(Health Check)

-

主动检查:负载均衡器定期向后端发送心跳请求(如HTTP 200状态码检测)。

-

被动检查:根据请求失败率自动标记故障节点(如Nginx的max_fails和fail_timeout)。

-

HAProxy配置示例:

backend web_servers

mode http

balance roundrobin

option httpchk GET /health

server s1 192.168.1.101:80 check inter 5s rise 2 fall 3

6. SSL终端卸载

-

功能:在负载均衡器上解密HTTPS,减轻后端服务器压力。

-

Nginx配置示例:

server {

listen 443 ssl;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://backend;

}

}

三、进阶优化与安全

会话保持(Session Persistence)

-

Cookie插入:HAProxy/Nginx可注入Cookie标识用户会话。

-

Redis集中存储会话:适用于无状态集群。

动态扩展

-

自动发现服务:结合Consul、Etcd实现服务注册与发现。

-

Kubernetes Ingress:在容器化环境中自动管理负载均衡。

安全防护

-

限速与防DDoS:通过Nginx的limit_req模块或云服务WAF。

-

黑白名单:限制IP访问(如Nginx的allow/deny规则)。

监控与日志

-

Prometheus+Grafana:监控负载均衡器与后端性能指标。

-

ELK Stack:分析访问日志(如Nginx的access_log)。

四、方案选型建议

-

中小型项目:Nginx/HAProxy + Keepalived,成本低且灵活。

-

高并发场景:LVS(DR模式) + Nginx七层代理,性能极致。

-

云原生环境:直接使用云厂商LB服务,省去运维成本。

-

金融/政府系统:硬件负载均衡器 + 冗余架构,确保高可靠。

通过以上方案,可构建高效、稳定的负载均衡系统,根据实际需求调整架构细节,并持续监控优化以应对业务增长。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册