基于深度卷积神经网络的医学图像自动识别系统设计与实现

📝分享的所有项目源码均包含(前端后台数据库),可做毕业设计或课程设计,欢迎留言分享问题&...

📝分享的所有项目源码均包含(前端后台数据库),可做毕业设计或课程设计,欢迎留言分享问题&...

在前面的内容 Pytorch深入浅出(七)之优化器(Optimizer)以及Pytorch进阶训练技巧&...

前言:推开那扇通往“上帝视角”的门 🌪️ 一场静悄悄的革命 把时针拨回 2017 年。 那时候的 AI 还在费劲地像小学生一...

Qwen2.5-coder-base 强化学习训练系统:RLOO算法实现 1. 项目概述与架构设计 1.1 项目目标 本项目旨在使用RLOO(Reinfo...

环境搭建(三):PyTorch/TensorFlow配置与电科金仓 KES-Python 连接实战 咱们这 100 ...

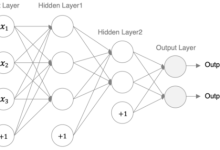

一、如何从零“搭建”一个神经网络? 大家好,很多初学者在入门深度学习时,常常会对“如何从零开始搭建一个神经网络”感到困...

🎬 Clf丶忆笙:个人主页 🔥 个人专栏:《YOLOv11全栈指南:从零基础到工业实战》 ⛺️ 努力不一定成功,但不努力一定不成功! 文章目录 一、PyT...

iRMB倒置残差块注意力机制简介 iRMB(Inverted Residual Mobile Block)的框架原理,...

🎬 1. 系统效果展示核心功能亮点深度学习内核:摒弃传统的矩阵分解,采用 PyTorch 实现何向南教授经典的 NC...

第一步:准备数据 6种蝴蝶数据:self.class_indict [\"曙凤蝶\", \"麝凤蝶\", \"多姿麝凤蝶\", ...