MCP火了!3月新建服务器数量暴涨300%,揭秘最真实的MCP生态

文章浏览阅读822次,点赞19次,收藏9次。在分析数据之前,先来说说MCP存在的意义以及它要解决的问题。对AI代理来说,最重要的并不是与用户对话,而是与外部服务...

文章浏览阅读822次,点赞19次,收藏9次。在分析数据之前,先来说说MCP存在的意义以及它要解决的问题。对AI代理来说,最重要的并不是与用户对话,而是与外部服务...

文章浏览阅读593次,点赞24次,收藏5次。新手必看:大模型推理入门指南,手把手教你从 0 构建模型,核心逻辑全讲透!

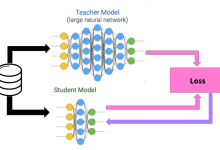

文章浏览阅读3次。大模型知识蒸馏(Knowledge Distillation)是什么?一篇文章讲透关键技术

文章浏览阅读58次。产品人必看:一文读懂 AI Agent 究竟是什么!

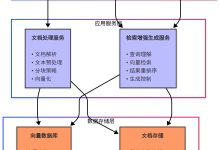

文章浏览阅读904次,点赞9次,收藏22次。系统必须能够处理PDF和Word(.docx)格式的文档未来可扩展支持其他格式(如PPT、Excel等)支持用户提交...

文章浏览阅读2.6k次,点赞88次,收藏71次。蓝耘智算云平台推出“MCP 广场”,集成众多 MCP 服务。注册登录后可进入广场选服务。以 DeepSeek M...

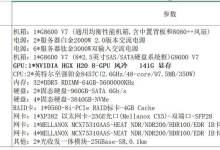

文章浏览阅读1k次,点赞36次,收藏8次。2025 年家用大模型服务器选型攻略:部署该怎么选?一文讲透!_大模型推理服务器配置

文章浏览阅读825次,点赞18次,收藏12次。最近给一家集团公司部署本地大模型,便写下本文记录一下**企业级生产环境部署大模型的全过程**。

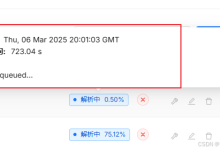

文章浏览阅读6.6k次,点赞22次,收藏21次。多半是因为模型确实在队列中排队的原因,要么是内存一直在被占用中,要么是CPU或GPU一直在被占用中,可以首先检查...

文章浏览阅读762次,点赞18次,收藏10次。支持导航到指定 URL提供截图功能以捕获页面状态支持点击、选择、填写表单字段等常见浏览器操作集成日志记录和异常处理...